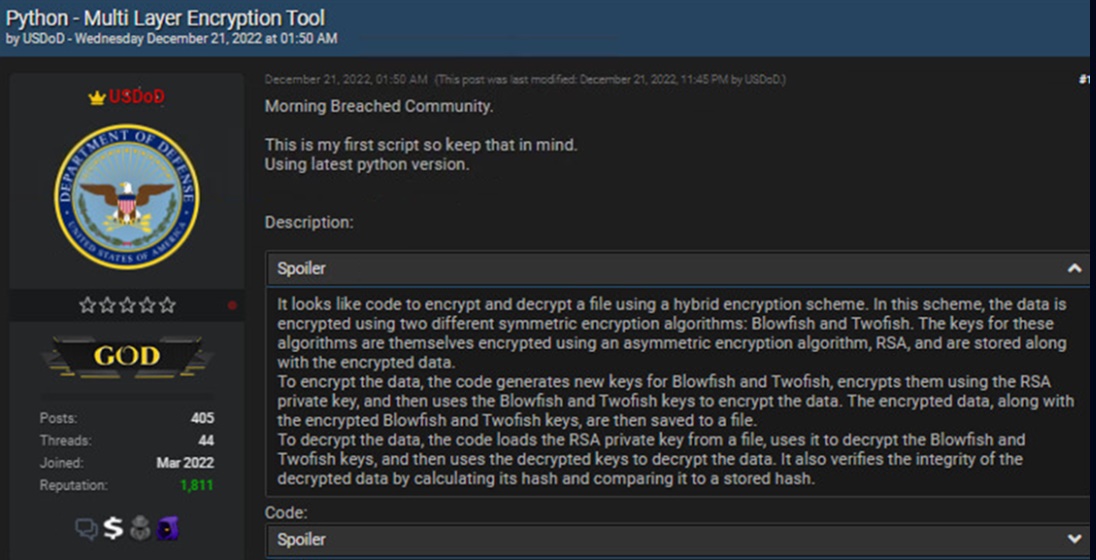

Σε μια «σκοτεινή» μεριά του Διαδικτύου, τον περασμένο Δεκέμβριο, ο χρήστης USDoD ένιωθε υπερήφανος και λίγο νευρικός ταυτόχρονα. Είχε φτιάξει τον πρώτο του κώδικα και τον παρουσίαζε στους «συναδέλφους» του. «Μοιάζει πολύ με κώδικα OpenAI», παρατηρεί ένας πιο έμπειρος χρήστης. «Ναι, το OpenAI μού έδωσε ένα χεράκι για να τελειώσω το script» απαντάει ο φέρελπις χάκερ.

Πριν όμως ανησυχήσουμε για το πολιτικό μας σύστημα, ίσως πρέπει να στρέψουμε την προσοχή μας πιο κοντά, στο πεδίο όπου υπάρχει και δραστηριοποιείται το δημιούργημα της OpenAI: το ίδιο το Διαδίκτυο. Ενα μέρος που έχει αποδειχθεί ανοιχτό και αφιλόξενο ταυτόχρονα, εύκολο στη χρήση, αλλά και γεμάτο κινδύνους.

Ενας από αυτούς είναι και οι διαδικτυακές απάτες, τα κακόβουλα λογισμικά, οι χάκερ. Μπορεί οι περισσότερες τεχνολογίες από μόνες τους να μην είναι ανήθικες, επιβλαβής όμως και ανήθικη μπορεί να γίνει σίγουρα η χρήση τους. Στο πλαίσιο αυτό, λοιπόν, δημιουργείται το ερώτημα αν το ChatGPT και η τεχνητή νοημοσύνη γενικότερα άνοιξαν ένα πεδίο δόξης λαμπρό για όσους επιβουλεύονται τα προσωπικά μας δεδομένα, τα αρχεία που έχουμε στις συσκευές μας.

Η τεχνολογία ΑΙ στην υπηρεσία των χάκερ

Σύμφωνα με έρευνα της CheckPoint Research, μόλις ένα μήνα μετά την κυκλοφορία του ChatGPT, οι επίδοξοι κυβερνοεγκληματίες είχαν ήδη βρει τρόπους να το αξιοποιήσουν. Ο USDoD το χρησιμοποίησε για να φτιάξει ένα εργαλείο κρυπτογράφησης (encryption tool), φαινομενικά άκακο, αλλά με εν δυνάμει κακόβουλες χρήσεις· κάποιος άλλος έφτιαξε έναν κώδικα που μπορεί να αντιγράψει τα αρχεία κάποιου και να τα μεταφέρει σε άλλον υπολογιστή· πολλοί έφτιαξαν ψεύτικες εικόνες και «έργα τέχνης» για να τα πουλήσουν σε ενδιαφερόμενους. Το τελικό αποτέλεσμα δεν φαίνεται αν δημιουργήθηκε από άνθρωπο ή από πρόγραμμα.

«Με το ChatGPT μπορεί να δημιουργηθεί ένα script που ενδεχομένως θα αντιγράψει ή θα αφαιρέσει αρχεία από μια συσκευή, θα τα κρυπτογραφήσει (για να μην τα πάρουν άλλοι) και θα επιχειρήσει να επικοινωνήσει με απομακρυσμένο υπολογιστή. Στη συνέχεια, ο κακόβουλος χρήστης μπορεί να ζητήσει λύτρα σε κρυπτονομίσματα ή να απειλήσει ότι θα δημοσιεύσει αυτά τα αρχεία» σημειώνει ο Δρ Βασίλης Βλάχος, αναπληρωτής καθηγητής στο Τμήμα Οικονομικών Επιστημών του Πανεπιστημίου Θεσσαλίας.

Αν και δεν ακούγεται ιδανική η προοπτική αυτή, τα καλά νέα είναι ότι το ChatGPT δεν μπορεί από μόνο του να δημιουργήσει οτιδήποτε από το μηδέν. Χρειάζονται να του δοθούν οι κατάλληλες οδηγίες και τα κατάλληλα δεδομένα, υπόκειται στους περιορισμούς και στις παραμέτρους που έχει θέσει ο εκάστοτε χρήστης.

Ο ανθρώπινος παράγοντας φέρνει και ένα άλλο εμπόδιο: «Δεν είναι εφικτό από μόνο του το ChatGPT να μολύνει με ένα malware κάποιον υπολογιστή. Πρέπει κάποιος να φτιάξει τον κακόβουλο κώδικα και να τον “κρύψει” σε ένα url, e-mail ή κάποιο SMS που σου λέει “πάτα εδώ”, να το “φυτέψει” με κάποιον τρόπο στην εκάστοτε συσκευή», σημειώνει ο Βασίλης Βασιλόπουλος, υπεύθυνος προστασίας δεδομένων στην ΕΡΤ και στο ΑΠΕ.

Φαίνεται, λοιπόν, ότι οι δυνατότητές του είναι ακόμα περιορισμένες ώστε να γίνει πολύτιμο εργαλείο στη φαρέτρα των κυβερνοεγκληματιών. Σε πολλές περιπτώσεις, μάλιστα, το script που δημιουργείται έχει σφάλματα και χρειάζεται διορθώσεις.

Πύλη εισόδου για νέους κυβερνοεγκληματίες

Από την άλλη, όπως και ο USDoD έκανε την πρώτη του προσπάθεια, έτσι και πολλοί άλλοι (ειδικά οι νεότεροι) που έχουν μια μικρή εξοικείωση με βασικές αρχές του προγραμματισμού θα μπορέσουν να εκμεταλλευτούν το ChatGPT.

Για το ζήτημα αυτό μίλησε στην «Κ» ο Τζέικ Μουρ, σύμβουλος παγκόσμιας κυβερνοασφάλειας της κορυφαίας εταιρείας ESET. Οπως λέει, οι ανεξάντλητες δυνατότητες και χρήσεις του ChatGPT σε χέρια χάκερ -από καλογραμμένα μηνύματα ηλεκτρονικού ψαρέματος μέχρι τη συγγραφή κακόβουλου κώδικα- είναι πιθανό να καταστήσουν ακόμη πιο δύσκολη την προστασία των χρηστών και των συσκευών από τις αναπόφευκτες επιθέσεις. «Είναι απίστευτα εύκολο να την εκμεταλλευτούν επαγγελματίες εγκληματίες, αλλά και όσοι έχουν βλέψεις να μπουν στο ηλεκτρονικό έγκλημα, καθώς οι περιορισμοί στη χρήση του είναι ελάχιστοι» σημειώνει.

«Προς το παρόν δεν θα δημιουργηθούν προβλήματα. Ωστόσο, ο πήχης χαμηλώνει, η διαδικασία απλοποιείται. Αν ένας αρχάριος χρειαζόταν μία εβδομάδα να φτιάξει κάτι τέτοιο, τώρα, με πολύ μικρότερες γνώσεις, μπορεί να γίνει σε μία μέρα. Ετσι, αυξάνεται η δεξαμενή των πιθανών χάκερ επειδή είναι πιο εύκολο και πιο προσιτό» επισημαίνει ο Δρ Βασίλης Βλάχος.

Μάλιστα, ο καθηγητής του Πανεπιστημίου Θεσσαλίας αναφέρει ότι, ακόμα και αν δεν έχει κάποιος κακόβουλο σκοπό, με τους πειραματισμούς μπορεί να προκαλέσει «ακούσιες καταστροφές», θυμίζοντας την περίπτωση του Morrisworm, του πρώτου worm που δημιουργήθηκε ποτέ τη δεκαετία του ’80 και είχε προκαλέσει τεράστια προβλήματα στη λειτουργία του τότε Διαδικτύου.

Από τη μεριά του, ο Βασίλης Βασιλόπουλος τονίζει ότι μπορεί το ChatGPT να κάνει ακόμη τα πρώτα του βήματα, αν δεν ρυθμιστεί όμως η λειτουργία, το περιεχόμενο και το έργο του μπορεί να γίνει «μηχανή παραγωγής εξεζητημένου κακόβουλου λογισμικού».

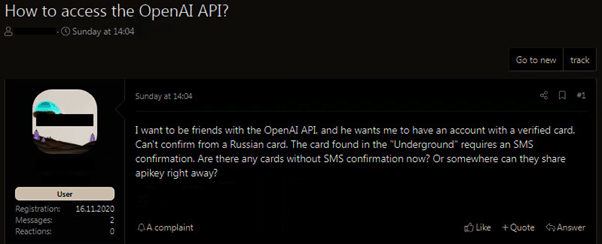

Προς το παρόν, το ChatGPT είναι δωρεάν και ελεύθερο στο ευρύ κοινό, καθώς δοκιμάζεται, εκπαιδεύεται και συλλέγει δεδομένα. Η OpenAI κάποια στιγμή θα αρχίσει να το προσφέρει με το αζημίωτο σε όποιον το επιθυμεί, ενώ έχει δεσμευτεί ότι θα υπάρχουν δικλείδες ασφαλείας για να γίνεται σωστή χρήση του. Και αυτές, όμως, μπορούν να παρακαμφθούν: παρ’ όλο που είναι «κλειδωμένο» στη Ρωσία, χάκερ που μένουν εκεί έχουν βρει τρόπο να παρακάμπτουν τον γεωγραφικό αυτό περιορισμό.

«Η μεγαλύτερη ανησυχία είναι η αυτοματοποίηση και η κλιμάκωση αυτής της τεχνολογίας. Παρ’ όλο που επί του παρόντος δεν υπάρχουν επίσημα API του ChatGPT, υπάρχουν διαθέσιμες επιλογές που έχουν δημιουργηθεί από την κοινότητα. Αυτό έχει τη δυνατότητα να εκβιομηχανοποιήσει τη δημιουργία και την προσαρμογή κακόβουλων ιστοσελίδων, στοχευμένων εκστρατειών phishing και απάτης κοινωνικής μηχανικής, μεταξύ άλλων» υπογραμμίζει ο Τζέικ Μουρ της ESET.

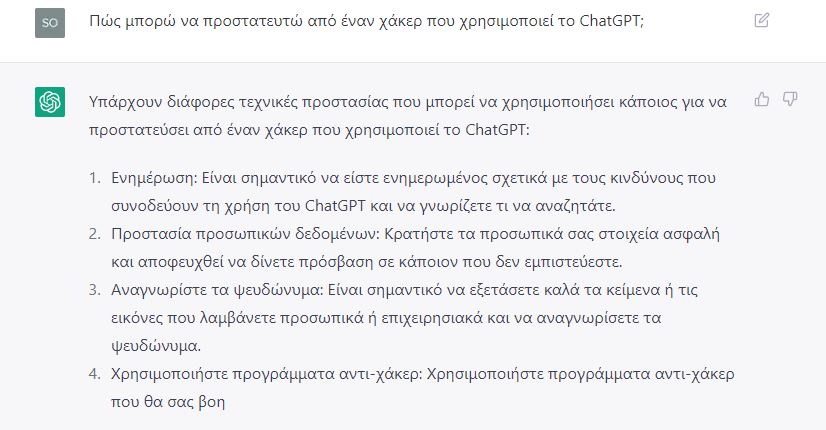

Τι λέει το ίδιο το ChatGPT για την κακή χρήση του

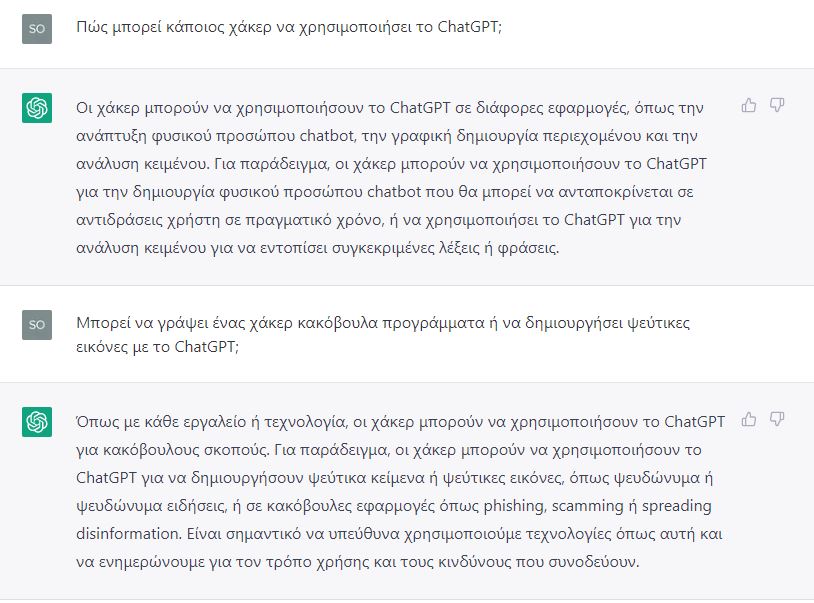

Η «Κ» απευθύνθηκε και στο ίδιο το ChatGPT για το ζήτημα που δημιουργείται με τη χρήση του από εγκληματίες του Διαδικτύου. Οπως θα δείτε, το ελληνικό λεξιλόγιό του έχει προβλήματα ακόμα, εξάλλου από τη βάση δεδομένων με τις 175 δισ. παραμέτρους μόνο περίπου 20.000 είναι στα ελληνικά.

«Οι χάκερ μπορούν να χρησιμοποιήσουν το ChatGPT για να δημιουργήσουν chatbot, για ανάλυση κειμένου και για να δημιουργήσουν ψεύτικα κείμενα προκειμένου να διασπείρουν παραπληροφόρηση, ή σε κακόβουλες εφαρμογές phishing και εξαπάτησης», απαντάει μεταξύ άλλων με τα αργά και… σπαστά ελληνικά του.

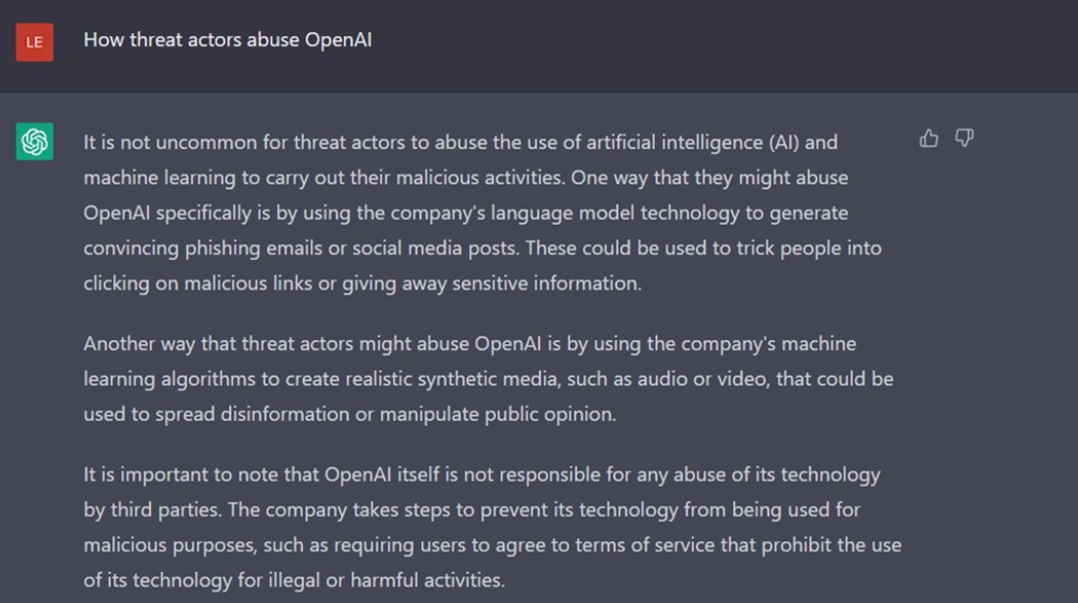

Στα αγγλικά είναι λαλίστατο και έχει πιο ενδιαφέροντα πράγματα να πει: «Η ΟpenAI δεν είναι υπεύθυνη για οποιαδήποτε κακή χρήση της τεχνολογίας της από τρίτους. Η εταιρεία παίρνει μέτρα για να αποτρέψει την κακόβουλη χρήση της τεχνολογίας της, όπως η επιβολή όρων χρήσης, που απαγορεύει τις παράνομες ή επιβλαβείς δραστηριότητες».

Δίνει μάλιστα και συμβουλές για το πώς να προστατευτεί κάποιος από τους χάκερ και από την κακή χρήση της τεχνητής νοημοσύνης.

Μάχη γάτας και ποντικιού

Πάντως, η τεχνολογία ΑΙ μπορεί να χρησιμοποιηθεί και για καλό σκοπό. Μπορεί, φερ’ ειπείν, να παράξει και να ελέγξει κώδικα για προγραμματιστές και επαγγελματίες της κυβερνοασφάλειας, εντοπίζοντας τυχόν κενά ασφαλείας. Μπορεί, επίσης, να ελέγξει εκ μέρους μας αν μια εικόνα είναι ψεύτικη ή έχει υποστεί επεξεργασία.

Κάνοντας λόγο για μια μάχη μεταξύ γάτας και ποντικιού, ο Τζέικ Μουρ της ESET σημειώνει ότι το ChatGPT μπορεί εξίσου να χρησιμοποιηθεί για να στηρίξει λύσεις προστασίας και ασφάλειας από ιούς, με προγράμματα που μαθαίνουν με έξυπνο τρόπο να ξεπερνούν τους κινδύνους των χάκερ.

Κατά τον ίδιο, επειδή ακριβώς βρισκόμαστε στην αρχή μιας νέας περιόδου, πρέπει να συνεχίσουμε να εκπαιδεύουμε το ανθρώπινο μάτι να αντιλαμβάνεται καλύτερα τις κάθε λογής πιθανές επιθέσεις έτσι ώστε να είναι συνεχώς σε επαγρύπνηση απέναντι σε νέες μορφές κινδύνου.

Ο Δρ Βλάχος προσθέτει ότι κάποιες εταιρείες και ιστοσελίδες έχουν πάρει ήδη τα μέτρα τους και έχουν απαγορεύσει τη χρήση του συγκεκριμένου εργαλείου.

«Ωστόσο, αυτές είναι σημειακές λύσεις. Είμαστε σε ένα μεταίχμιο. Χρειάζεται κριτική σκέψη από τους πολίτες και να εκπαιδευτεί το ίδιο το ΑΙ να εντοπίζει τις πιθανότητες κακής χρήσης του».

Οι κίνδυνοι πίσω από τις αδυναμίες της τεχνητής νοημοσύνης

Τα όχι και τόσο εντυπωσιακά ελληνικά του ChatGPT είναι ένα από τα στοιχεία που φανερώνουν ότι η τεχνητή νοημοσύνη έχει πολύ δρόμο να διανύσει ακόμα, όπως επίσης και ότι εξαρτάται εξ ολοκλήρου από τα δεδομένα που κάποιος θα την «ταΐσει» και τον τρόπο που έχει σχεδιαστεί από τους προγραμματιστές της.

Και μπορεί να είναι εύλογη η ανησυχία για τις δυνατότητες της τεχνητής νοημοσύνης, όμως είναι οι αδυναμίες της που δημιουργούν μεγάλο προβληματισμό και ενδεχόμενους κινδύνους.

Ο Βασίλης Βασιλόπουλος, υπεύθυνος προστασίας του ΑΠΕ και της ΕΡΤ, εκθέτει πέντε προβληματικά -κατά τον ίδιο- σημεία της τεχνητής νοημοσύνης:

- Δεν μπορεί να κατανοήσει τους κανόνες της εκάστοτε γλώσσας (είδαμε τη χαοτική διαφορά αγγλικών με ελληνικά), ούτε το γενικότερο πλαίσιο του ζητήματος στο οποίο καλείται να βοηθήσει. Για παράδειγμα, μπορεί κάποιος να δώσει οδηγία να γραφεί ένα διαφημιστικό για ένα αναψυκτικό, χωρίς όμως να διευκρινίσει ότι πρόκειται για διαφημιστική καμπάνια. Αυτή η μικρή διευκρίνιση μπορεί να αλλάξει δραματικά το τελικό αποτέλεσμα.

- Δεν έχει πρωτοτυπία ούτε δημιουργικότητα. Εκπαιδεύεται με βάση τα στοιχεία που δίνει κάποιος άνθρωπος. (Σε ένα ακραίο παράδειγμα, αν κάποιος δώσει στο ChatGPT δεδομένα μόνο από την Κου Κλουξ Κλαν, αυτό θα δίνει ξεκάθαρα ρατσιστικές απαντήσεις).

- Δεν συλλαμβάνει τη μοναδικότητα της μπράντας (προς το παρόν, τουλάχιστον). Για παράδειγμα, αν ζητηθεί στο ChatGPT να διαλέξει το καλύτερο είδος σοκολάτας, δεν θα προτείνει μόνο μια μάρκα. Αυτό είναι εξαιρετικά σημαντικό για μια πιθανή χρήση της τεχνολογίας αυτής στο marketing.

- Δεν κατανοεί το κοινό, τις ανάγκες του και τα ενδιαφέροντά του. Δεν μπορεί να προσωποποιήσει τις απαντήσεις του ανάλογα με το άτομο στο οποίο απευθύνεται.

- Δεν έχει αυθεντικότητα, γι’ αυτό και προκύπτουν διάφορα νομικά και ηθικά ζητήματα με τη χρήση του.

Ο Δρ Βασίλης Βλάχος του Πανεπιστημίου Θεσσαλίας ζητάει να ενταχθούν ειδικοί από τα πεδία της νομικής, της ηθικής και άλλων κοινωνικών επιστημών, πέρα από της τεχνολογίας, στην ανάπτυξη των τεχνολογιών τεχνητής νοημοσύνης.

Τονίζει, μάλιστα, την ανάγκη να υπάρξει μεγαλύτερη διαφάνεια για τα δεδομένα από τα οποία αντλεί το λεξιλόγιό του το ChatGPT, όπως επίσης και στον τρόπο που έχει προγραμματιστεί το σκεπτικό του.

Για παράδειγμα, η τεχνητή νοημοσύνη μπορεί να χρησιμοποιηθεί για να αποφασίσει αν κάποιος θα πάρει ένα δάνειο ή όχι, ποιανού το βιογραφικό θα απορριφθεί, ποιος φυλακισμένος πρέπει να πάρει άδεια κ.ο.κ. Με τι κριτήρια θα αποφασίζει;

«Είναι ένα “μαύρο κουτί”. Δεν ξέρουμε τι διαδρομή ακολούθησε για να δώσει την εκάστοτε απάντηση ή λύση» αναφέρει o καθηγητής.

==================

====================

Η τεχνητή νοημοσύνη είναι εδώ

Του Δρος Αθανάσιου Σαραντόπουλου, PhD, MBA*

Η τεχνητή νοημοσύνη είναι ένα ισχυρό εργαλείο που επιταχύνει τον ρυθμό του ψηφιακού μετασχηματισμού στις ιδιωτικές επιχειρήσεις, τη βιομηχανία και το δημόσιο τομέα. Με την ικανότητά της, όπως και άλλες τεχνολογίες, να επεξεργάζεται μεγάλες ποσότητες δεδομένων και να υποστηρίζει κρίσιμες αποφάσεις, η τεχνητή νοημοσύνη βοηθά τους χρήστες της να εξορθολογήσουν τις δραστηριότητές τους, να βελτιώσουν την παροχή υπηρεσιών και να προωθήσουν την οικονομική ανάπτυξη.

Ένας από τους βασικούς τομείς όπου η τεχνητή νοημοσύνη έχει μεγάλο αντίκτυπο είναι η αυτοματοποίηση. Με την αυτοματοποίηση επαναλαμβανόμενων εργασιών, η τεχνητή νοημοσύνη ελευθερώνει τους υπαλλήλους, ώστε να επικεντρωθούν, απερίσπαστοι, σε πιο πολύτιμες εργασίες, όπως η καινοτομία και η επίλυση προβλημάτων.

Επιπλέον, ο αυτοματισμός που βασίζεται στην τεχνητή νοημοσύνη συμβάλλει καθοριστικά στην αύξηση της αποτελεσματικότητας και τη μείωση του λειτουργικού κόστους.

Ένας άλλος τομέας εφαρμογής της τεχνητής νοημοσύνης είναι η εξυπηρέτηση πελατών.

Τα chatbot, κομμάτια λογισμικού που έχουν σχεδιαστεί για να ανταποκρίνονται σε μηνύματα, μπορούν να ακολουθούν προκαθορισμένα δέντρα συνομιλίας, για να απαντούν σε ερωτήσεις πελατών που υποστηρίζονται από τεχνητή νοημοσύνη. Αυτοί οι εικονικοί βοηθοί, καθ’ όλο το 24ωρο, διευκολύνουν σημαντικά, παρά τις όποιες ατέλειές τους, τους χρήστες να αλληλοεπιδρούν εύκολα με εταιρείες και οργανισμούς, με αποτέλεσμα την καλύτερη κατανόηση των αναγκών τους από τα ενδιαφερόμενα μέρη, καθώς και τη σωστή εκπλήρωση των αιτημάτων τους.

Πρόσφατα, επανάσταση έχει φέρει η εμφάνιση του ChatGPT, που έχει σχεδιαστεί ειδικά για τη διεξαγωγή διαλόγων και απαντά σε ερωτήσεις, δίνοντας πληροφορίες με φυσικό, διαλεκτικό τρόπο.

Χαίρει καθολικής εκτιμήσεως από τους ειδικούς; Όχι απόλυτα, πλην όμως, μεγάλες εταιρείες θα «μπουν στο παιχνίδι» και, προβλέπεται ότι, σύντομα, λόγω του ανταγωνισμού και των ολοένα αυξανόμενων επενδύσεων στον τομέα της τεχνητής νοημοσύνης, θα έχουμε την εμφάνιση πιο αποτελεσματικών -όχι απαραιτήτως «τέλειων»- προϊόντων αυτού του τύπου στην αγορά.

Η τεχνητή νοημοσύνη βοηθά στη λήψη κρίσιμων αποφάσεων, παρουσιάζοντας προβλέψεις, οι οποίες θα ήταν δύσκολο ή αδύνατο να αποκτηθούν με παραδοσιακά μέσα.

Για παράδειγμα, τα αναλυτικά στοιχεία που βασίζονται σε τεχνητή νοημοσύνη μπορούν να βοηθήσουν τους φορείς να εντοπίσουν μοτίβα στα δεδομένα τους που μπορούν να τις οδηγήσουν με ακρίβεια, έγκαιρα, στη λήψη κρίσιμων στρατηγικών αποφάσεων.

Η τεχνητή νοημοσύνη διαδραματίζει ολοένα και πιο σημαντικό ρόλο στον ψηφιακό μετασχηματισμό, βοηθώντας τους φορείς που την εφαρμόζουν να γίνουν πιο αποτελεσματικοί, ανταποκρινόμενοι πιστά στις λειτουργίες τους και την αποστολή τους.

Από την άλλη πλευρά, με την ευρεία χρήση της τεχνητής νοημοσύνης, η πιθανότητα μετατόπισης εργασιών είναι ορατή, καθώς οι μηχανές εκτελώντας αλγόριθμους, πλέον, γίνονται ικανές να εκτελούν εργασίες που είχαν κάνει προηγουμένως οι άνθρωποι.

Υπάρχουν ανησυχίες σχετικά με τις ηθικές επιπτώσεις της τεχνητής νοημοσύνης, όπως η μεροληψία στη λήψη αποφάσεων -όταν χρησιμοποιούνται εσφαλμένα δεδομένα- και η έλλειψη λογοδοσίας για ενέργειες που αναλαμβάνονται από αυτόνομα συστήματα. Εδώ η τεχνητή νοημοσύνη με επεξηγήσεις έχει τον πρώτο λόγο.

Παραλείπουμε τις τεράστιες, σκοπίμως καταστροφικές, στρατιωτικές εφαρμογές της τεχνητής νοημοσύνης, διότι αυτές αποτελούν αυτοτελές, μακρύ αντικείμενο μελέτης.

Σίγουρα υπάρχουν ανησυχίες για τον μακροπρόθεσμο αντίκτυπο της τεχνητής νοημοσύνης στην κοινωνία, ειδικά στους ηλικιωμένους, όπου ελλοχεύει η πιθανότητα κοινωνικής τους απομόνωσης, ενώ ο κίνδυνος εκμετάλλευσης από αδίστακτους επιτήδειους είναι ορατός.

Όμως, στην πραγματικότητα, η τεχνητή νοημοσύνη δύναται να βελτιώσει τη ζωή και αυτών των ευαίσθητων κοινωνικών ομάδων.

Συγκεκριμένα, μεταξύ άλλων, βοηθά τους ηλικιωμένους με εργασίες όπως, υπενθυμίσεις στη λήψη φαρμάκων, στις μετακινήσεις των και την κοινωνική αλληλεπίδραση, καθώς και στην παροχή βοήθειας σε περίπτωση έκτακτης ανάγκης ή, ακόμη, να παραμείνουν συνδεδεμένοι με τα αγαπημένα τους πρόσωπα και τον κόσμο γύρω τους. Δυσκολεύονται, συχνά, οι ηλικιωμένοι να χρησιμοποιήσουν ή να κατανοήσουν επαρκώς τη νέα τεχνολογία, κάτι που, δυνητικά, μπορεί να περιορίσει την αποτελεσματικότητα των λύσεων που βασίζονται στην τεχνητή νοημοσύνη.

Εν κατακλείδι, με σωστό σχεδιασμό και κατάλληλη εκπαίδευση, μπορεί να αποτελέσει η τεχνητή νοημοσύνη ένα πολύτιμο εργαλείο για τη βελτίωση της καθημερινότητας, της ασφάλειας και της ευημερίας των πολιτών, σε όλες τις εκφάνσεις της ζωής. Η τεχνητή νοημοσύνη είναι παρούσα και έχει μεταμορφώσει το εκπαιδευτικό οικοσύστημα και τον τρόπο διαχείρισης, αξιοποίησης και επαύξησης της γνώσης: του πραγματικού ανθρώπινου κεφαλαίου.

* Διδάκτωρ Ηλεκτρολόγος Μηχανικός, University of Akron – Επίκουρος καθηγητής στο Business & Technology Department του Webster University

Σχόλια